Bildung und Karriere / Gesellschaft und Lifestyle / Wissenschaft und Technik

Wer sagt hier eigentlich was? Künstliche Intelligenz und die Zukunft des Schreibens

ChatGPT und Co: KI ist gerade ein heißes Thema in den Medien. Wir wagen einen Erklärungsversuch und einen Ausblick. Wo geht die Reise hin?

Midjourney

MidjourneyDie Themen „Künstliche Intelligenz“ und insbesondere „ChatGPT“ sind aktuell in aller Munde und der Fokus der Berichterstattung reicht von Lobeshymnen über die Verbesserung der Arbeitswelt, bis zu Dystopien rund um Datenschutz, Urheberrechte und Maschinen, die Menschen ersetzen werden. Wir haben uns das Programm genauer angeschaut, es selbst ausprobiert und setzen uns mit ein paar der Fragen und Problemen auseinander.

Was ist ChatGPT?

ChatGPT (Generative Pre-trained Transformer) ist eine Software, die auf Machine Learning, also einer Form künstlicher Intelligenz basiert. Es wurde vom Institut OpenAI entwickelt, einem der führenden Unternehmen im Bereich der KI-Technologien. Das Programm wurde speziell dafür konzipiert, menschenähnliche Konversationen in natürlicher Sprache zu führen und ist in der Lage, auf Fragen zu antworten, Ratschläge zu geben und sogar Witze zu erzählen.

Die Funktionsweise von ChatGPT beruht auf dem Konzept der sogenannten Generative Pre-trained Transformer 3 (GPT-3)-Modelle. Diese Programme werden mit riesigen Datenmengen trainiert, um komplexe Zusammenhänge in der Sprache zu verstehen und präzise Vorhersagen darüber zu treffen, welche Inhalte, also welche Wörter, Sätze und Aussagen, in einem gegebenen Kontext wahrscheinlich folgen werden. Die Technik ist bei weitem nicht so neu, wie es scheint: Schon 2018 ist das erste Modell der Art erschienen, das hat aber noch nicht so viel Aufmerksamkeit außerhalb einer kleinen Informatik-Community bekommen. Warum ist es auf einmal so populär? Das liegt neben besseren Texten und einem besseren Interaktionsverhalten vor allem an der verbesserten Nutzbarkeit: Um eine Konversation mit ChatGPT zu beginnen, geben User einfach eine Frage oder einen Befehl ein oder unterhalten sich wie in WhatsApp und Co. mit dem Tool. Das Programm analysiert dann den Kontext der Frage und generiert eine Antwort auf der Grundlage des Modells und der verfügbaren Daten.

ChatGPT lernt ständig dazu, indem es eine Vielzahl von Datenquellen, vor allem Texte aus dem Internet, analysiert und auswertet. Dadurch wird das Programm immer besser darin, menschenähnliche Konversationen zu führen und genauere und detailliertere Antworten zu geben. Mit ChatGPT können Nutzer*innen auf eine völlig neue Art und Weise mit Computern interagieren und von einer schnellen und effizienten Kommunikation profitieren. Aber wie gut ist dieser Algorithmus wirklich? Und können wir damit einen Text schreiben (lassen), den man auf den ersten Blick gar nicht als automatisch generiert erkennt? Das haben wir ausprobiert und einen seitenwaelzer-Artikel mit ChatGPT verfasst – und es ist niemandem aufgefallen, jedenfalls von denjenigen, die wir dazu befragt haben. Es geht um den Text mit dem Titel „Freie Zeit für eine bessere Welt? Das Ehrenamt und seine Probleme„.

Zaubere uns einen Text – ein Experiment

Das Ganze klingt fast schon magisch einfach: Man gibt dem Computer die Aufgabe, einen Text zu schreiben und es baut sich ein inhaltlich, stilistisch, grammatikalisch und orthografisch richtiger Text auf. Ganz so einfach ist es aber dann doch nicht. Zwar unterfüttert ChatGPT die Texte mit (halbwahren) Informationen oder etwas, das stark danach aussieht, aber mit „Schreibe einen Artikel“ ging es dann doch nicht. Stattdessen mussten wir uns die Struktur des Textes selbst ausdenken, jeden Abschnitt mit einer Haupt-Fragestellung und einigen Stichpunkten versehen und haben den Algorithmus anschließend beauftragt, uns die einzelnen Kapitel separat zu schreiben. Das ging dann ungefähr so:

Bitte schreibe nun den zweiten Abschnitt des Textes „Einführung ins Thema Ehrenamt in Deutschland“ mit folgenden Ausführungen: Wie viele Menschen in Deutschland arbeiten ehrenamtlich? Was sind die meisten Bereiche, in denen das Ehrenamt zum Tragen kommt? Was sind Gründe für Menschen, ehrenamtlich zu arbeiten?

Schritt für Schritt haben wir so also Textbausteine erhalten, die wir teilweise nachkorrigieren lassen mussten, etwa wenn sie keine gute Struktur hatten oder nicht zum Rest des Textes passten. Ein wenig redaktionelle Lenkung war also nötig. Trotzdem waren wir beeindruckt vom Ergebnis, denn obwohl wir das inhaltliche Lektorat absichtlich ausgelassen haben, haben unsere tollen Lektor*innen einmal mit dem Fokus auf Rechtschreibung und Zeichensetzung draufgeschaut und tatsächlich so gut wie keine Fehler im Text entdeckt. Die Inhalte sind aber ein ganz anderer Fall: Denn ChatGPT halluziniert sich Fakten herbei. Das können Fakten sein, Quellen, Zahlen oder Lebensläufe. Leider werden diese Inhalte nicht gekennzeichnet, sondern das Programm spuckt mit völliger Selbstverständlichkeit Märchen aus, die alle manuell überprüft werden müssen. Grund dafür ist, dass es nicht zwischen Wahrheit und Mythos unterscheiden kann. Wir erinnern uns: Es wird nur ein Text auf Basis von Wahrscheinlichkeiten generiert.

Unsere Learnings

Doch was nehmen wir selbst mit aus diesem Versuch? Ganz grundsätzlich können wir feststellen, dass der Bot seine Aufgabe erfüllt hat. Nicht überragend, es ist mit Sicherheit kein journalistisches Meisterwerk über das Ehrenamt entstanden. Erfahrene Journalist*innen würden eine Botschaft stärker vermitteln – sofern der Text das soll – oder im Stil einer Reportage Fakten deutlicher machen und kritische Aspekte beleuchten. All das ist hier nur am Rande geschehen, der Artikel ist vielmehr eine allgemeine Übersicht geworden.

Mit ebenso großer Gewissheit stellen die Ausführungen von ChatGPT und den modernen Sprachbots (für andere Bots können wir nicht mit Gewissheit sprechen) aber auch keinen Fehlschlag dar. Solange es um den reinen Schreibauftrag geht, sind die Formulierungen sprachlich sauber, grammatikalisch in Ordnung und bewegen sich auf einem teils sehr hohen Formulierungsniveau. Doch dafür hat es eines hohen Aufwandes bedurft. Wie bereits im Abschnitt über die Entstehung beschrieben, kann der GPT eigene komplette Texte noch nicht in ausreichender Tiefe verfassen. So sind weiterhin Konkretisierungen, zielgenaue Schreibanweisungen und Kontrollen notwendig. Es ist jedoch davon auszugehen, dass dies in zukünftigen Versionen des Bots nicht mehr nötig sein wird. Die KI entwickelt sich weiter, auch wenn damit neue Herausforderungen einhergehen.

Ein großes Manko, welches aktuell in von GPT erstellten Artikeln oder anderen Texten zu beobachten ist, ist die „Scheu“ vor einem Urteil. So laufen beispielsweise Fragen nach der Bewertung einer Umweltkatastrophe ins Leere. GPT kann hier zwar verschiedene Perspektiven anreißen, vielleicht sogar teilweise vertieft behandeln, aber nicht den letzten Schritt einer abschließenden Bewertung vollziehen. Dies zeigt sich insbesondere in den verwaschenen Formulierungen in Argumentationen. Dieser Bot bezieht keine Stellung, will keine Meinung vertreten. Und das soll auch so sein! Es handelt sich bei GPT um eine KI, die auf Kommunikationssituationen trainiert ist, und nicht darauf, Daten auszuwerten und zu beurteilen. Und so kommt es am Ende eines jeden Schreibprozesses doch noch auf den Faktor Mensch an, um aus den – wie auch immer zusammengetragenen – Fakten ein Kondensat zu produzieren und dieses in journalistischen Artikeln oder anderen Texten zu verteidigen. GPT ersetzt nicht die Meinungsbildung!

Welcher Ausblick bleibt?

Die bloße Existenz von GPT und anderen Bots bedroht – überspitzt formuliert – die Existenz von gesellschaftswissenschaftlichen und akademischen Professionen. Wofür braucht es noch Journalist*innen, Akademiker*innen oder sogar Lehrer*innen, wenn eine KI Texte verständlich und einfach formulieren kann, Informationen bündelt und auswertet? Letztendlich für eben den einen Schritt, der in Schulen, Universitäten und anderen Bildungseinrichtungen in Aufgaben oder Prüfungen als „Anforderungsbereich III“ (Bewerten, Beurteilen, Reflexion) bekannt ist.

Ein Bot hat Vorteile, vor allem in der reinen Zusammenfassung von Informationen. Von GPT erstellte Texte sind sprachlich gut; sie überschreiten – wenn man dem Hörensagen aus akademischen Kreisen Glauben schenken darf – die Fähigkeiten so mancher Studierenden der Geisteswissenschaften. Wenn also die sprachliche Kompetenz nicht mehr im Vordergrund steht und Fakten einfach produziert werden können, dann verlagert sich der Fokus automatisch auf die Ebene, in der über Texte reflektiert werden muss. Ist das, was der Bot geschrieben hat, inhaltlich gut, ist es verständlich geschrieben oder welche Argumentationsstruktur wird bedient? Für Studierende und Schüler*innen stellt sich somit immer zwingender die Frage: Welche Meinung möchte ich in meiner Hausarbeit, meinem Referat vertreten? Wenn also die Reflexion über Sprache, die produzierten Texte und deren (rhetorische) Wirkweise von zunehmender Relevanz ist, so bedeutet dies zweierlei.

Zum einen dürfen Universitäten, Schulen und auch Redaktionen ihre Augen nicht vor der digitalen Entwicklung verschließen. Die Recherche ist weiterhin notwendig, alleine deswegen, um GPT mit Daten zu füttern, auf die der Bot sonst keinen Zugriff hätte. Im wissenschaftlichen Kontext heißt das, die Literaturrecherche zwar selbst durchzuführen, aber GPT die Paraphrase übernehmen zu lassen. Denn für diese Aufgabe ist der Algorithmus entworfen worden! Von der Universität Münster ist GPT als eine neue „Herausforderung“ für die Universität eingestuft worden. Noch ist offen, wie die KI in den universitären Alltag integriert werden kann, aber vorläufig heißt es: „die Nutzung von textgenerierenden KI-Systemen ist grundsätzlich nicht zulässig„. Doch wo liegt hier tatsächlich die Grenze? Dass ein vollständig generierter Text als Rechtsverstoß verstanden wird, liegt auf der Hand: Die Eigenleistung, ohne Recherche, gleicht null. Doch eine Paraphrase abzulehnen, obschon Word selbst eine Thesaurusfunktion hat, ist fraglich.

Neben den rechtlichen Fragen bedeutet die zunehmende Relevanz der Sprachreflexion, also über die Wirkweise von Texten nachzudenken, dass auch Schulen diese Entwicklung mitgehen müssen. Dies erscheint grundsätzlich weniger aufwändig. So wird in Schulen zwar auch Faktenwissen vermittelt, aber die Kernlehrpläne für alle Schulformen, sehen den Kompetenzzuwachs von Schüler*innen als Hauptaufgabe der Schulen. Hier fällt die Sprachreflexion unter die ohnehin vorgesehenen und zu unterrichtenden Kompetenzen, mindestens im Deutschunterricht. Doch auch in der Sprachreflexion ist die Rede vom höchsten Anforderungsbereich – Beurteilen ist schließlich nicht Beschreiben. Es geht nicht darum, ein Argument erkennen zu können, es geht um die Wirkung. Und nicht alle Schüler*innen erreichen alle Kompetenzziele. Damit wird eine Frage drängender: Welche Folgen hat es, wenn nicht alle Schüler*innen die Kompetenz der Sprach- und Textreflexion hinreichend erwerben? Bedeutet dies, dass es in Zukunft Arbeitnehmer*innen gibt, die fähig sind, eine KI kritisch zu hinterfragen, andere wiederum nicht?

Realistisch gesehen wird GPT alle Berufe, die auf die Textproduktion ausgerichtet sind, aufwirbeln. Die Tendenz, Texte zu erstellen, die „nur“ für den einmaligen Gebrauch gedacht sind (etwa E-Mails oder Werbetexte), wird hoffentlich abnehmen, sodass relevante Fragen verstärkt fokussiert werden. Negativ gesehen, könnte es auch Jobs gefährden und vor allem gibt es da das Problem mit den Problemen.

Noch sind Algorithmen, die Texte, Musik oder Bilder erstellen oder andere kreative Aufgaben verrichten, in unserer Gesellschaft ziemlich neu, da es einen ganzen Haufen Probleme mit den Tools gibt. Wir führen nun ein paar davon an, die sich vor allem auf Texterstellung und Bilderstellung beziehen.

Hier fallen etwa rechtliche Probleme ins Auge. Wem gehören eigentlich die erstellten Texte? Dem Algorithmus? Den Ersteller*innen? Der Firma, die den Algorithmus entwickelt hat? Und wie sieht es mit dem Trainingsmaterial aus? Bildgeneratoren wie Dall-E oder Midjourney haben gelernt, indem sie mit Unmengen von Bildern von Künstler*innen aus aller Welt gefüttert wurden. Und auch ChatGPT lernt, indem es Texte von Menschen analysiert und immer besser darin wird, diese zu imitieren. Dabei hat natürlich niemand wirklich zugestimmt, dass die eigenen, oft kreativen Inhalte diesen Tools zur Verfügung gestellt wurden. Und auch moralisch ist es ein wirkliches Problem: Wenn quasi jede*r ein Bild im Stil eines beliebten oder bekannten Kunstschaffenden in wenigen Sekunden erstellen kann, welchen Wert haben dann Original und Imitation? Und sind es überhaupt Imitate? Entgegen weitläufiger Meinungen kopieren diese Programme nicht. Sie plagiieren also nicht, sie lernen vom Ausgangsmaterial, lernen, dessen Regeln zu verstehen und wenden sie anschließend an. Ähnlich, wie wir vielleicht die Regeln des Bauhauses oder des Impressionismus lernen und nach diesen Regeln und durch die Inspiration verschiedener Künstler*innen ein Produkt schaffen könnten. Denn auch ein Mensch könnte ja einen Stil betrachten, analysieren und anschließend in diesem Stil ein Bild malen oder einen Text schreiben. Müssen wir Stile besser schützen? Eine Frage, die erst noch geklärt werden muss. Hierzu gibt es aber schon einige interessante Diskussionen im Netz, wie diese Folge aus dem Podcast „Rechtsbelehrung“ über Rechtsfragen bei KI.

Ein weiteres moralisches Problem ist die Contentprüfung: Wie auch in Kommentarbereichen, Foren oder in sozialen Netzwerken, gibt es immer Trolle oder Menschen, die Inhalte erstellen möchten, die nicht gern gesehen oder sogar strafrechtlich verboten sind. Menschen müssen die Programme also kontrollieren und prüfen und genau darauf setzen die Software-Hersteller: Es gibt Personen, die sich den ganzen Tag Gewaltdarstellungen, Pornografie und noch viel Schlimmeres anschauen müssen und davon psychische Traumata davontragen. Das passiert zu unzumutbaren Bedingungen in Ländern, die sich kaum gegen die Praktiken großer Konzerne schützen können, für ChatGPT etwa in Kenia. Hierzu gibt es einen interessanten Artikel im Time Magazine. Wenn ihr mehr über sogenannte Cleaners für Facebook, Twitter und Co. erfahren möchtet, schaut euch unbedingt den Dokumentarfilm „The Cleaners“ an.

Und dann ist da noch das Problem der Perspektive. Was gibt mir ChatGTP eigentlich für eine Weltsicht? Was hat es gelernt? Von wem? Stellt euch vor, ihr wärt ein Geschöpf, das in einem Raum ohne Bezug zur Außenwelt aufwachsen würde und ihr hättet all euer Wissen nur über eine Handvoll YouTube-Kanäle. Natürlich wüsstet ihr hinterher sehr viel über DIY, Schminktipps und Computertutorials, aber je nachdem welche Kanäle das wären, würdet ihr auch rassistische, gefährliche oder möglicherweise anderweitig sehr einseitige Inhalte konsumieren. Und das hat natürlich einen Einfluss darauf, wie man die Welt sieht: „Kultivierung“ lautet der Fachbegriff der Kommunikationswissenschaft dafür, dass Medien einen Einfluss auf unser Wissen, Denken und Handeln haben können. Algorithmen wie ChatGPT hinterfragen Inhalte im Vergleich zu uns Menschen aber nicht, sondern nehmen erst mal alles für bare Münze. So fiel relativ früh auf, dass Bildgeneratoren wie Stable Diffusion etwa ein sehr statisches Bild davon haben, was sie als „Standard“ ausgegeben. Wenn ich etwa nach Bildern von König*innen, Pilot*innen oder einer anderen Bezeichnung suche, kommen immer Menschen (meistens männlich gelesen) mit einem stereotypen Aussehen, das weißen Mitteleuropäer*innen zugeschrieben wird, heraus. Beispiele findet ihr in diesen beiden Artikeln rund um Gender-Bias oder Rassismus und Sexismus. Menschen anderer Hautfarbe, anderen Alters oder sonstiger Gruppen, findet man kaum bis gar nicht. Und so stellt sich auch bei einem Textgenerator die Frage, woher er seine Inhalte hat und was uns die vielen Antworten auf unsere Eingaben am Ende für ein Bild von der Welt vermitteln.

Doch keine Utopie?

Wir haben jetzt sehr viele Probleme und Fragen aufgeworfen und das klingt alles schon eher negativ. Trotzdem sind all dies nur Probleme auf dem Weg zu einer Technologie, die uns wahnsinnig viel Arbeit abnehmen, Prozesse vereinfachen und neue Wege zu kreativem Ausdruck schaffen kann – wenn wir sie ethisch nutzen. Und im Grunde ist das auch schon die Basis für viele Technologien: Du bestimmst, wie du damit umgehst. Noch sind diese Tools neu, das bedeutet, wir haben noch keine Medienkompetenz aufgebaut, aber in Zukunft werden wir das müssen. Die Probleme mit Falschinformationen, Urheberrecht, Datenschutz oder Kultivierung sind nicht ganz neu und unsere individuellen Lösungen gelten eigentlich für Social Media und den Umgang im Netz überhaupt: Wir sollten Inhalte wie Texte und Bilder noch kritischer prüfen, unser Weltbild erweitern und bei eigenen Texten unsere Quellen offenlegen. Und einfach keinen Scheiß machen. Und daher möchten wir am Ende noch einmal alle aufrufen: Nutzt Technologie für etwas Gutes. Verbessert damit die Welt.

Unterstützen

Wenn dir der Beitrag gefallen hat, würden wir uns über eine kleine Spende freuen.

Noch mehr Stories? Folge seitenwaelzer:

Robin Thier

Gründer von seitenwaelzer, lebt in Münster und beschäftigt sich in seiner freien Zeit mit Bildbearbeitung, Webseitengestaltung, Filmdrehs oder dem Schreiben von Artikeln. Kurz: Pixelschubser.

Moritz Flottmann

Lebt als Student der Germanistik und Geographie in Münster. Ist meistens im AStA oder reisend irgendwo in der Welt zu finden – und wenn das nicht reicht wird auch noch gekocht.

StockSnap | Pixabay

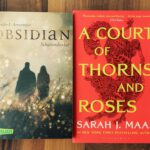

StockSnap | Pixabay Lese-Lust im Sommer – Empfehlungen der Redaktion

Ein Herz für Enten

Sandra Hein

Sandra Hein Tatsächlich gelesen: In 300 Buchseiten um die Welt oder die Sache mit dem Mut

Ana Soraya da Silva Lopes | seitenwaelzer.de

Ana Soraya da Silva Lopes | seitenwaelzer.de Im Wandel (Teil 2): Wie die Literatur Frauenbilder widerspiegelt

Tags: AiAlgorithmusAuswirkungenChatGPTEthikKIMaschineMenschmoralRoboterZukunft

Das Experiment der Autoren mit ChatGPT zur Erstellung eines Textes zum Thema Freiwilligenarbeit verdeutlicht eindrucksvoll die Stärken und Schwächen dieser Technologie. Obwohl sie grammatikalisch fundierte Inhalte generieren kann, hat die KI Probleme mit der sachlichen Genauigkeit und ist nicht in der Lage, eine kritische Analyse durchzuführen.

Ein spannender Beitrag! Künstliche Intelligenz verändert nicht nur das Schreiben, sondern auch unsere Vorstellung von Autorschaft. Wichtig ist, den kreativen Prozess bewusst zu reflektieren.

Spannender Einblick in KI-Textproduktion! Kurz gesagt: KI wie ChatGPT kann glänzende Sprache liefern, aber nur mit klaren Vorgaben – und oft mit „halbwahren“ Details. Die Autor:innen zeigen schön, wie wichtig menschliches Lektorat, Faktencheck und Bewertung bleiben – auch in Zukunft. Eine wirklich fundierte Reflexion zur Frage: Wer schreibt eigentlich?